Votre premier réflexe pour lancer un projet IA est de vouloir recruter un "Data...

Votre premier réflexe pour lancer un projet IA est de vouloir recruter un "Data...

Vos collaborateurs utilisent déjà ChatGPT et d'autres IA génératives, que vous le...

Utiliser ChatGPT dans un onglet séparé de votre navigateur, c'est comme avoir une...

Vous êtes convaincu du potentiel de l'IA, mais votre direction reste sceptique face à un...

"L'intelligence artificielle, c'est formidable, mais au final, combien ça coûte et,...

Le PoC (Proof of Concept) a été un succès. L'équipe était enthousiaste, les premiers...

En tant que manager, vous êtes en première ligne. Vous percevez le potentiel de l'IA...

Vous avez décidé d'encadrer l'usage de l'IA plutôt que de l'interdire. Excellente...

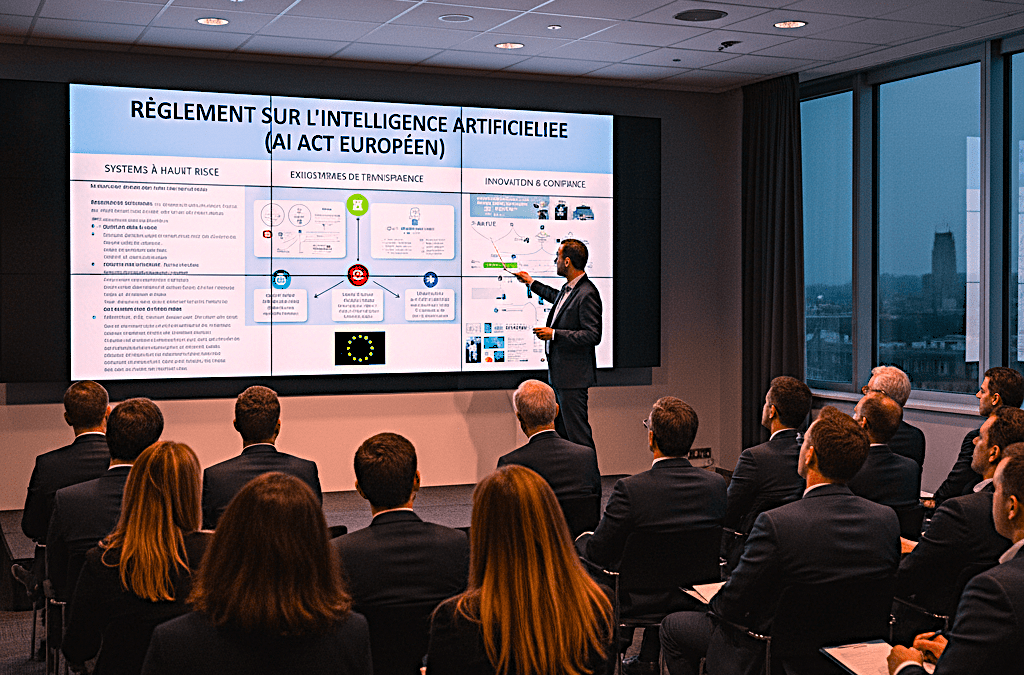

L'AI Act européen arrive, et avec lui son lot d'interrogations et d'inquiétudes pour les...

Vous êtes convaincu. L'intelligence artificielle n'est plus une option, c'est une...

Envoyer les données de vos clients ou des informations stratégiques vers des modèles d’IA publics comme ChatGPT est le chemin le plus court vers une violation du RGPD et une crise de confiance. Pourtant, se priver de l’IA par peur des risques de confidentialité, c’est laisser un avantage concurrentiel majeur à vos compétiteurs. La bonne nouvelle ? Il existe des solutions techniques et organisationnelles robustes pour concilier performance de l’IA et respect absolu des données. Cet article vous explique comment faire.

Lorsque vous utilisez la version gratuite et publique de grands modèles de langage, vous devez partir d’un principe simple : tout ce que vous y entrez peut être réutilisé. Les conditions d’utilisation de ces services stipulent généralement que les données soumises peuvent être utilisées pour améliorer et entraîner les futurs modèles. Votre information confidentielle devient une partie de la « connaissance » du modèle.

Du point de vue du RGPD, l’utilisation de ces outils avec des données personnelles pose trois problèmes majeurs :

Face à ce constat, trois grandes approches techniques permettent d’utiliser la puissance de l’IA tout en gardant le contrôle de vos données.

L’idée est de « nettoyer » les données avant de les envoyer à un modèle d’IA, même public. Cela consiste à détecter et à remplacer toutes les informations d’identification directe (nom, prénom, email, téléphone, adresse…) par des marqueurs génériques (ex:

[NOM_CLIENT],

[EMAIL]).

Exemple de prompt pseudonymisé :

« Rédige une réponse à

[NOM_CLIENT]

qui se plaint d’un retard de livraison pour sa commande n°

[NUM_COMMANDE]

. Son email est

[EMAIL_CLIENT]

. Sois empathique et propose un bon d’achat de 10%. »

Le RAG est une petite révolution dans l’utilisation sécurisée de l’IA. L’idée est la suivante : le grand modèle d’IA (LLM) ne va pas « apprendre » vos données. Il va simplement les « lire » pour répondre à une question, puis les « oublier » instantanément.

Analogie : Imaginez que vous engagez un consultant expert de renommée mondiale, mais qui est totalement amnésique.

Techniquement, c’est ce que fait le RAG : vos données confidentielles sont stockées dans une base de données privée et sécurisée. Quand vous posez une question, le système va chercher les informations pertinentes dans votre base, les injecte dans le prompt envoyé à l’IA avec l’instruction « Réponds à la question en te basant uniquement sur ce texte », et l’IA génère la réponse sans jamais stocker l’information source.

C’est l’option « forteresse ». Elle consiste à prendre un modèle d’IA, souvent open-source (comme Llama 3, Mistral…), et à l’installer et le faire tourner sur vos propres serveurs (on-premise) ou sur une instance de cloud qui vous est entièrement dédiée et isolée (cloud privé), idéalement hébergée en Europe.

Choisir la bonne architecture technique est crucial, mais ne suffit pas. Vous devez l’accompagner d’une gouvernance rigoureuse :

Le choix de la bonne approche dépend de votre niveau de sensibilité des données, de votre budget et de vos compétences internes.

| Approche | Niveau de Sécurité | Complexité Technique | Coût | Idéal pour… |

|---|---|---|---|---|

| Anonymisation | Faible à Moyen | Faible | Faible | …des tests rapides et des usages non-critiques. |

| RAG | Élevé | Moyenne | Moyen | …la plupart des PME/ETI voulant utiliser leurs données de manière sécurisée. |

| Modèle Privé | Très Élevé | Élevée | Élevé | …les grandes entreprises avec des données ultra-sensibles. |

Pour la grande majorité des PME et ETI, une combinaison d’anonymisation systématique et la mise en œuvre progressive d’une approche RAG (souvent via un prestataire spécialisé ou une solution « Enterprise » qui l’intègre) représente aujourd’hui le meilleur équilibre entre sécurité, performance et maîtrise des coûts. Concilier IA et RGPD n’est pas seulement possible, c’est une nécessité pour innover en toute confiance.

Votre premier réflexe pour lancer un projet IA est de vouloir recruter un "Data...

Vos collaborateurs utilisent déjà ChatGPT et d'autres IA génératives, que vous le...

Utiliser ChatGPT dans un onglet séparé de votre navigateur, c'est comme avoir une...

Vous êtes convaincu du potentiel de l'IA, mais votre direction reste sceptique face à un...

"L'intelligence artificielle, c'est formidable, mais au final, combien ça coûte et,...

Le PoC (Proof of Concept) a été un succès. L'équipe était enthousiaste, les premiers...

En tant que manager, vous êtes en première ligne. Vous percevez le potentiel de l'IA...

Vous avez décidé d'encadrer l'usage de l'IA plutôt que de l'interdire. Excellente...

L'AI Act européen arrive, et avec lui son lot d'interrogations et d'inquiétudes pour les...

Vous êtes convaincu. L'intelligence artificielle n'est plus une option, c'est une...